这篇文章介绍下LYZ-GPT学术版更换模型功能介绍和可用的配置作用。

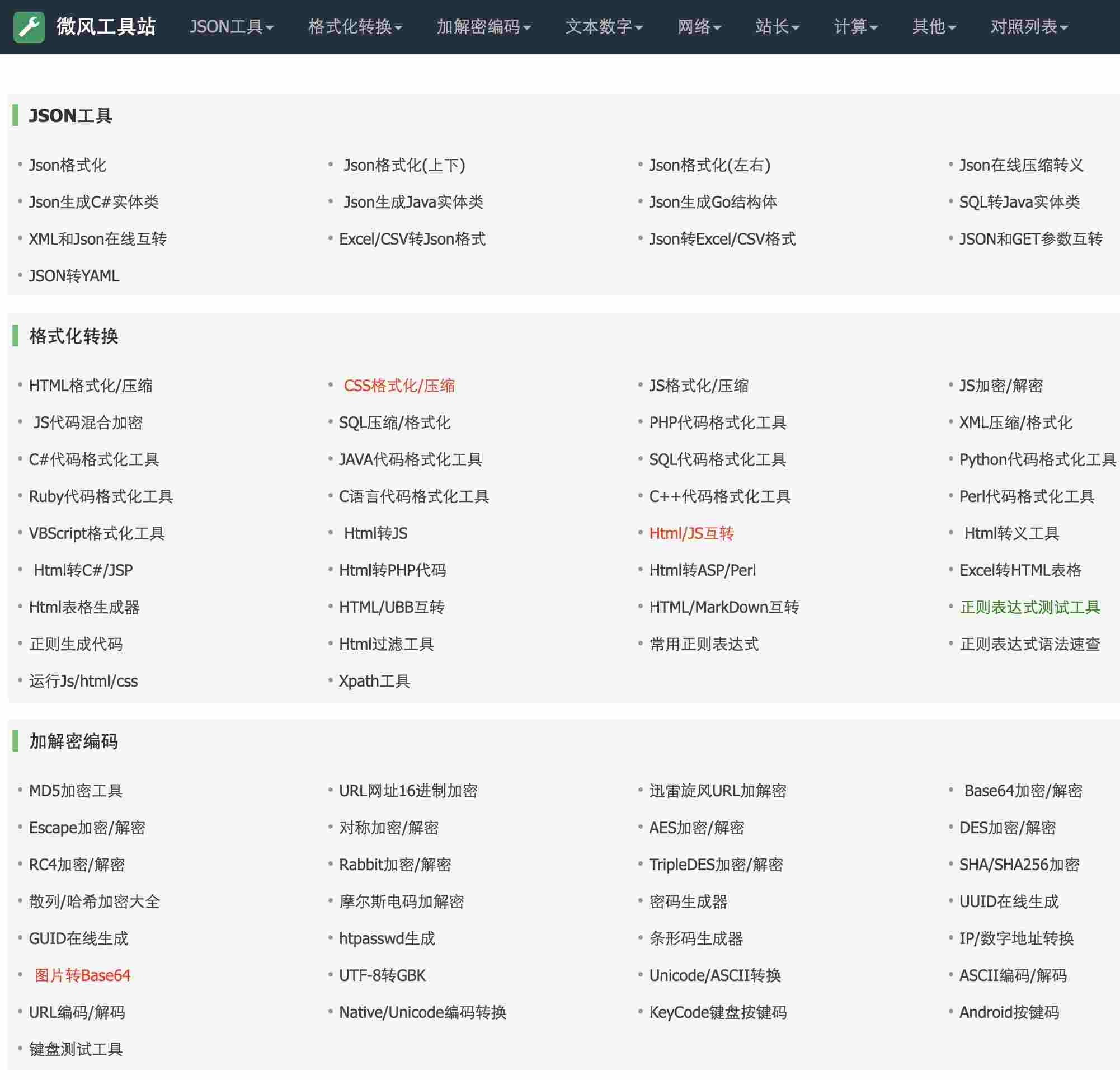

配置布局

![图片[1]|GPT学术版更换模型功能介绍及配置详解|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/gpt/moxing.png)

1、LLM模型

LLM大模型是指使用大量文本数据训练的深度学习模型,可以生成自然语言文本或理解语言文本的含义。LLM可以处理多种自然语言任务,如文本分类、问答、对话等,是通向人工智能的一条重要途径。

LLM的核心思想是通过大规模的无监督训练来学习自然语言的模式和语言结构,这在一定程度上能够模拟人类的语言认知和生成过程。与传统的NLP模型相比,LLM能够更好地理解和生成自然文本,同时还能够表现出一定的逻辑思维和推理能力。

LYZGPT支持gpt-3.5-turbo-1106、gpt-4-1106-preview、gpt-4-vision-preview、gpt-3.5-turbo-16k、gpt-3.5-turbo、gpt-4、gpt-4-32k 7种由OpenAI发布的大语言模型。模型的特点和区别,如何选用可以查看下面这篇文章。

2、采样百分比

在了解Top-p参数之前,需要了解GPT训练模型的Tokens是什么。

在GPT类模型中,tokens可以理解为用于将输入文本切分成一个个可处理的单元。这些tokens可以是单词片段,也可以包括尾随空格甚至子单词。在处理文本时,GPT会将输入的文字转换成tokens,然后通过模型预测这些tokens,再将它们转换成文字,最后输出。总的来说,tokens是自然语言处理的最细粒度。

了解了Tokens,那么Top-p参数就很容易理解了。

在训练GPT类模型时,Top-p参数常常被设置为0.9或0.95。Top-p,又名Nucleus Sampling(核采样),与Top-k不同,它不是固定选取前k个tokens,而是根据设定的概率阈值来选取tokens。例如,将Top-p设定为0.15,即选择前15%概率的tokens作为候选。

3、回答创意性

用于控制模型输出的结果的随机性,这个值越大随机性越大。一般我们多次输入相同的prompt之后,模型的每次输出都不一样。

1、设置为 0,对每个prompt都生成固定的输出。

2、较低的值,输出更集中,更有确定性。

3、较高的值,输出更随机(更有创意⭐)。

在GPT中,Prompt指的是模型生成回复的初始文本,通常是用户发出的问题或话题。可以理解为一种“指令”,能够提供一些关键词或者场景信息,帮助GPT更好地理解用户输入的问题或需求,从而生成更加准确、符合要求的回答。

此外,Prompt也用于指导模型输出内容的质量和风格。在生成文本时,GPT会根据Prompt的内容生成一段文本作为输出。通过调整Prompt的内容和风格,可以控制GPT输出的文本内容、长度和风格等。

因此,Prompt在GPT中扮演着非常重要的角色,可以帮助用户更好地与模型进行交互,从而获得更加准确和有用的信息。

一般来说,prompt 越长,描述得越清楚,模型生成的输出质量就越好,置信度越高,这时可以适当调高temperature 的值;反过来,如果 prompt 很短,很含糊,这时再设置一个比较高的 temperature 值,模型的输出就很不稳定了。

遇事不决就调参,调一下,万一就生成了不错的回答呢?

Local LLM MaxLength

Local LLM MaxLength是指本地语言模型的最大长度。这个参数用于限制模型在处理输入时的最大长度,以防止模型在处理长文本时计算效率低下的问题。在LLM类模型中,输入文本会被切分成多个tokens,每个tokens都会被转换成向量表示,然后通过模型进行预测。如果输入文本过长,会导致模型处理效率下降,因此需要限制最大长度。

![GPT学术版功能简介[更多功能开发完善中]|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/gpt/gptdesktop.png)

![GPT免费API KEY分享[免费公益版]|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/gpt/api.png)

![GPT学术版一键聚合文献+写RelatedWorks[文献检索]|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/gpt/s5.png)

![开启GPT3.5/4.0/Dall-e-3模型绘画[gpt4.0,专业绘画免费体验]|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/home/chatgpt.png)

![学术GPT学术论文生成指南[7步法生成高质量论文]|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/gpt/78.png)

![GPT学术版如何生成长文、长论文[技巧]|LYZ-ling云智](https://cdnimg.lyzplus.cn/lyzplus/gpt/lunwen.webp)

![表情[ciya]|LYZ-ling云智](https://www.lyzplus.cn/wp-content/themes/zibll/img/smilies/ciya.gif)

![表情[guzhang]|LYZ-ling云智](https://www.lyzplus.cn/wp-content/themes/zibll/img/smilies/guzhang.gif)

![表情[hanxiao]|LYZ-ling云智](https://www.lyzplus.cn/wp-content/themes/zibll/img/smilies/hanxiao.gif)

暂无评论内容